À medida que mais empresas começam rapidamente a utilizar a geração AI, é importante evitar um grande erro que pode afetar a sua eficácia: a integração adequada. As empresas gastam tempo e dinheiro treinando novos trabalhadores humanos para terem sucesso, mas quando usam auxiliares de modelo de linguagem grande (LLM), muitos os tratam como ferramentas simples que não precisam de explicação.

Isto não é apenas um desperdício de recursos; é arriscado. A pesquisa mostra que a IA avançou rapidamente dos testes para o uso real em 2024 a 2025, com quase um terço das empresas relatando um aumento acentuado no uso e aceitação em relação ao ano anterior.

Os sistemas probabilísticos precisam de governança, não de ilusões

Ao contrário do software tradicional, a geração AI é probabilística e adaptativa. Ele aprende com a interação, pode variar conforme os dados ou o uso mudam e opera na zona cinzenta entre a automação e a agência. Tratá-lo como se um software estático ignorasse a realidade: sem monitoramento e atualizações, os modelos se degradam e produzem resultados defeituosos: um fenômeno amplamente conhecido como desvio do modelo. Gen AI também carece de recursos integrados inteligência organizacional. Um modelo treinado em dados da Internet pode escrever um soneto de Shakespeare, mas não conhecerá seus caminhos de escalada e restrições de conformidade, a menos que você o ensine. Os reguladores e os organismos de normalização começaram a promover orientações precisamente porque estes sistemas se comportam de forma dinâmica e podem ter alucinações, enganar ou vazar dados se não forem controlados.

Os custos reais de pular a integração

Quando os LLMs alucinam, interpretam mal o tom, vazam informações confidenciais ou amplificam preconceitos, os custos são tangíveis.

-

Desinformação e responsabilidade: Um tribunal canadense responsabilizou a Air Canada depois que o chatbot de seu site forneceu a um passageiro informações incorretas sobre a política. A decisão deixou claro que as empresas continuam responsáveis pelas declarações dos seus agentes de IA.

-

Alucinações embaraçosas: Em 2025, uma “lista de leitura de verão” distribuída pelo Chicago Sun Times e Inquiridor da Filadélfia livros recomendados que não existiam; o escritor usou IA sem verificação adequada, provocando retratações e demissões.

-

Viés em escala: O primeiro acordo sobre discriminação de IA da Comissão de Igualdade de Oportunidades de Emprego (EEOCs) envolveu um algoritmo de recrutamento que rejeitava automaticamente candidatos mais velhos, sublinhando como os sistemas não monitorizados podem amplificar preconceitos e criar riscos legais.

-

Vazamento de dados: Depois que os funcionários colaram códigos confidenciais no ChatGPT, a Samsung baniu temporariamente ferramentas públicas de IA em dispositivos corporativos – um passo em falso evitável com melhores políticas e treinamento.

A mensagem é simples: a IA não integrada e o uso não governado criam exposição legal, de segurança e de reputação.

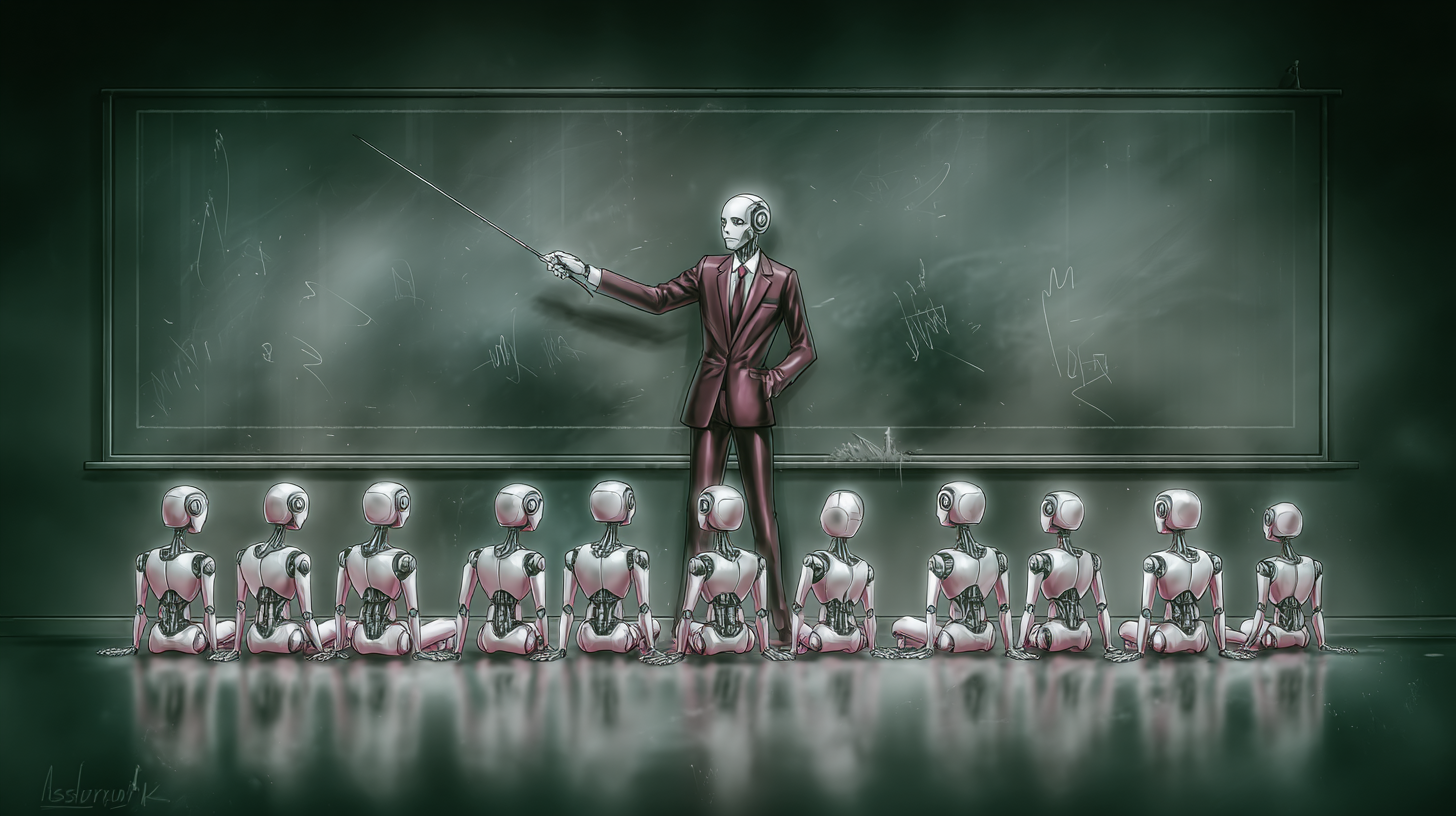

Trate os agentes de IA como novos contratados

As empresas devem integrar agentes de IA tão deliberadamente quanto integram pessoas – com descrições de cargos, currículos de treinamento, ciclos de feedback e avaliações de desempenho. Este é um esforço multifuncional entre ciência de dados, segurança, conformidade, design, RH e usuários finais que trabalharão com o sistema diariamente.

-

Definição de função. Explique o escopo, entradas/saídas, caminhos de escalonamento e modos de falha aceitáveis. Um copiloto jurídico, por exemplo, pode resumir contratos e revelar cláusulas arriscadas, mas deve evitar julgamentos legais finais e escalar casos extremos.

-

Treinamento contextual. O ajuste fino tem seu lugar, mas para muitas equipes, a geração aumentada de recuperação (RAG) e os adaptadores de ferramentas são mais seguros, mais baratos e mais auditáveis. O RAG mantém modelos baseados em seu conhecimento mais recente e comprovado (documentos, políticas, bases de conhecimento), reduzindo alucinações e melhorando a rastreabilidade. As integrações emergentes do Model Context Protocol (MCP) facilitam a conexão de copilotos a sistemas corporativos de maneira controlada – unindo modelos com ferramentas e dados, preservando a separação de interesses. O Einstein Trust Layer da Salesforce ilustra como os fornecedores estão formalizando bases seguras, mascaramento e controles de auditoria para IA corporativa.

-

Simulação antes da produção. Não deixe que o primeiro “treinamento” da sua IA seja com clientes reais. Crie sandboxes de alta fidelidade e teste o tom, o raciocínio e os casos extremos e, em seguida, avalie com avaliadores humanos. O Morgan Stanley criou um regime de avaliação para seu assistente GPT-4, fazendo com que consultores e engenheiros de prompt avaliassem as respostas e refinassem os prompts antes da implementação ampla. O resultado: >98% de adoção entre as equipes de consultores, uma vez atingidos os limites de qualidade. Os fornecedores também estão migrando para a simulação: a Salesforce destacou recentemente os testes de gêmeos digitais para ensaiar os agentes com segurança em cenários realistas.

-

4) Mentoria multifuncional. Trate o uso precoce como um ciclo de aprendizagem bidirecional: Especialistas do domínio e usuários da linha de frente dão feedback sobre o tom, a correção e a utilidade; as equipes de segurança e conformidade impõem limites e linhas vermelhas; os designers moldam UIs sem atrito que incentivam o uso adequado.

Ciclos de feedback e avaliações de desempenho – para sempre

A integração não termina com a entrada em operação. A aprendizagem mais significativa começa depois Implantação.

-

Monitoramento e observabilidade: Registre resultados, rastreie KPIs (precisão, satisfação, taxas de escalonamento) e observe a degradação. Os provedores de nuvem agora fornecem ferramentas de observabilidade/avaliação para ajudar as equipes a detectar desvios e regressões na produção, especialmente para sistemas RAG cujo conhecimento muda ao longo do tempo.

-

Canais de feedback do usuário. Forneça sinalização no produto e filas de revisão estruturadas para que humanos possam treinar o modelo e, em seguida, feche o ciclo alimentando esses sinais em prompts, fontes RAG ou conjuntos de ajuste fino.

-

Auditorias regulares. Programe verificações de alinhamento, auditorias factuais e avaliações de segurança. Os manuais de IA empresarial responsável da Microsoft, por exemplo, enfatizam a governança e as implementações graduais com visibilidade executiva e proteções claras.

-

Planejamento de sucessão para modelos. À medida que as leis, produtos e modelos evoluem, planeje atualizações e aposentadorias da mesma forma que planejaria transições de pessoas – execute testes de sobreposição e transmita conhecimento institucional (instruções, conjuntos de avaliações, fontes de recuperação).

Por que isso é urgente agora

A Gen AI não é mais um projeto de “prateleira de inovação” – ela está incorporada em CRMs, centrais de suporte, pipelines de análise e fluxos de trabalho executivos. Bancos como o Morgan Stanley e o Bank of America estão a concentrar a IA em casos de utilização de copilotos internos para aumentar a eficiência dos funcionários e, ao mesmo tempo, restringir os riscos enfrentados pelos clientes, uma abordagem que depende de uma integração estruturada e de uma definição cuidadosa do âmbito. Enquanto isso, os líderes de segurança dizem que a geração AI está em toda parte, ainda um terço dos adotantes não implementaram mitigações básicas de riscouma lacuna que convida à IA sombra e à exposição de dados.

A força de trabalho nativa da IA também espera melhor: transparência, rastreabilidade e capacidade de moldar as ferramentas que utiliza. As organizações que oferecem isso – por meio de treinamento, recursos claros de UX e equipes de produto responsivas – veem uma adoção mais rápida e menos soluções alternativas. Quando os usuários confiam em um copiloto, eles usar isto; quando não o fazem, eles o ignoram.

À medida que a integração amadurece, espere ver Gerentes de capacitação de IA e Especialistas em PromptOps em mais organogramas, curadoria de prompts, gerenciamento de fontes de recuperação, execução de conjuntos de avaliação e coordenação de atualizações multifuncionais. A implementação interna do Copilot da Microsoft aponta para esta disciplina operacional: centros de excelência, modelos de governança e manuais de implantação prontos para executivos. Esses profissionais são os “professores” que mantêm a IA alinhada com os objetivos de negócios em rápida evolução.

Uma lista de verificação prática de integração

Se você estiver introduzindo (ou resgatando) um copiloto empresarial, comece aqui:

-

Escreva a descrição do trabalho. Escopo, entradas/saídas, tom, linhas vermelhas, regras de escalonamento.

-

Aterre o modelo. Implemente RAG (e/ou adaptadores estilo MCP) para conectar-se a fontes autorizadas e com acesso controlado; prefira o aterramento dinâmico em vez do ajuste fino amplo, sempre que possível.

-

Construa o simulador. Criar cenários com script e propagados; medir precisão, cobertura, tom, segurança; exigem aprovações humanas para os estágios de graduação.

-

Navio com guarda-corpos. DLP, mascaramento de dados, filtros de conteúdo e trilhas de auditoria (consulte camadas de confiança do fornecedor e padrões de IA responsável).

-

Feedback do instrumento. Sinalização, análises e painéis no produto; agendar triagem semanal.

-

Revise e treine novamente. Verificações mensais de alinhamento, auditorias factuais trimestrais e atualizações planejadas de modelos — com A/Bs lado a lado para evitar regressões.

Num futuro em que cada funcionário terá um colega de equipa com IA, as organizações que levarem a integração a sério agirão de forma mais rápida, segura e com maior propósito. A geração AI não precisa apenas de dados ou computação; precisa de orientação, metas e planos de crescimento. Tratar os sistemas de IA como membros da equipe que podem ser ensinados, melhorados e responsáveis, transforma o entusiasmo em valor habitual.

Dhyey Mavani está acelerando a IA generativa no LinkedIn.

Fonte ==> Cyberseo